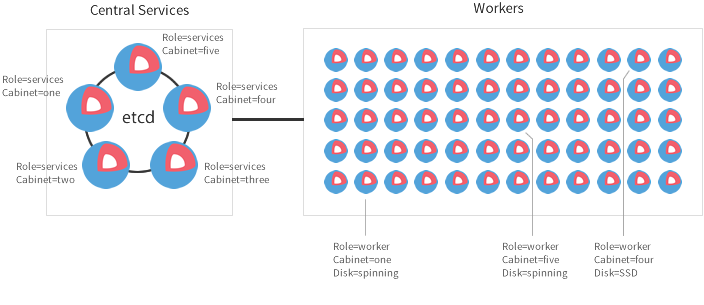

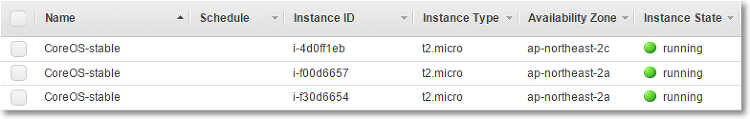

오늘은 CoreOS cluster architecutres 문서에 기술된 Production cluster with central services를 구축해보려고 합니다. 큰 규모의 서비스를 운영해야하는 경우 이 아키텍쳐를 사용하는 것이 좋습니다. 3~5개의 머신으로 etcd 클러스터를 별도로 구성하고 Worker 머신에는 etcd를 Proxy로 실행시키는 방식입니다. 그러면 Worker는 etcd proxy를 통해 Central Services의 etcd를 사용할 수 있습니다. etcd Proxy는 etcd 클러스터의 write 성능에 아무런 영향을 끼치지 않는다고 하네요. Security Group 생성Security Group을 하나 생성합니다. 저는 SSH 접속을 위해 22번 포트를 열었고, etc..